Digital

15.07.2018, 11:4916.07.2018, 08:35

Folgen

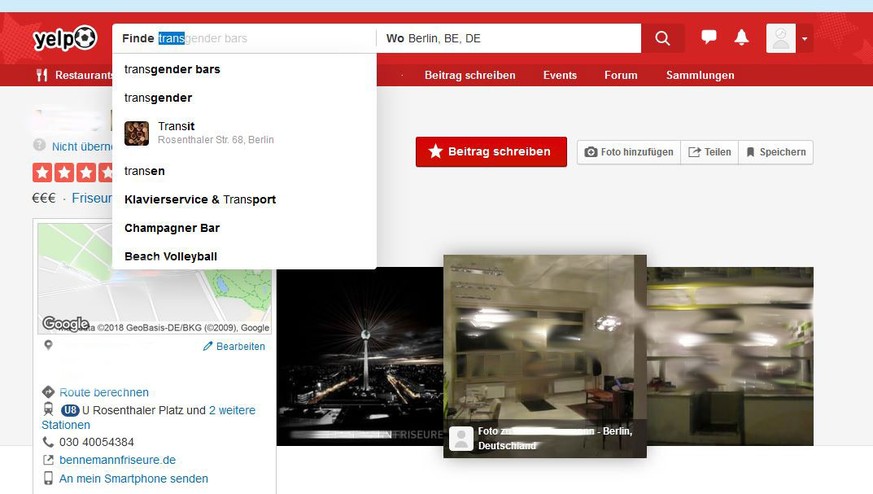

Wer gerade bei der Empfehlungs-App Yelp in Berlin nach einem Lokal sucht, der bekommt auch transphobe Vorschläge.

Wer etwa beginnt "Tra" zu tippen, bekommt den Begriff "Transe" in der Autovervollständigung vorgeschlagen:

Der Begriff wird meist abwertend und verletztend für Trans-Menschen verwendet. Und es gibt ihn nicht nur in der deutschen Yelp-App auf. Zuvor hatte das US-amerikanische Nachrichtenmagazin Daily Beast über Probleme bei Yelp US berichtet.

Dort tauchte der transgender-feindliche Begriff "Tranny" immer wieder in den Suchanfragen auf. Wer das ganze Wort "Tranny" eingab, bekam in San Francisco sogar den Suchvorschlag "Tranny Massage" angeboten.

Das transphobe System

Eins vorweg, Yelp hat nicht alleine Probleme mit transphobem Vokabular. Sie kommen durch die Algorithmen zustande, die Plattformen wie Yelp häufig benutzen und programmieren.

Es handelt sich dabei um Computerprogramme, die Suchergebnisse und Newsfeeds für uns vorfiltern. Durch sie können Anbieter wie Facebook oder eben Yelp die für uns am interessantesten Such-Ergebnisse, Posts und Nachrichten präsentieren. Die Software dahinter ist meist ein gut gehütetes Geschäftsgeheimnis.

In der Vergangenheit gab es deshalb immer wieder Probleme:

Weil sie mit unseren Daten arbeiten, füttern wir Algorithmen auch mit unseren Vorurteilen, Fantasien und Meinungen. Eben mit allem, was wir so den lieben langen Tag online eintippen.

So lässt sich auch erklären, dass die Yelp-App das Wort "Transe" mit bestimmten Lokalen in Berlin in Verbindung bringt. Vermutlich gab es zuvor viele Yelp-User, die Beleidigungen wie diese über die Besucher oder Besitzer mehrere Lokale in die Kommentare geschrieben hatten. Die App hat diesen Input dann verarbeitet und selbst angeboten.

Der Extremfall:

Wo sowas enden kann, zeigte schon 2016 das Chat-Programm "Tay" von Microsoft.

Auf Twitter sollte es mit jungen Usern interagieren und mit den gewonnen Daten immer schlauere Sätze schreiben können:

Die Programme können auch Inhalte unterdrücken, die völlig ok sind:

Ende 2017 etwa blockte ein Algorithmus von Twitter Bilder, die unter den Hasthags #Bisexual und #Bisexuality liefen. Nur, weil das Filter-Programm einen pornographischen Zusammenhang annahm.

Unter dem Strich gibt es zahllose Beispiel für Probleme, die durch Algorithmen auftauchen: Von der Suchanfrage, die nur weiße Menschen zeigt. Über das Löschen von kritischen inhalten. Bis hin zu automatisch generierten YouTube-Videos für Kinder, die brutalste Szenen zeigen. Alles kommt aus dem System.

Die große Debatte

Nun lassen sich Programme nicht einfach kontrollieren oder überwachen, wie das oft gefordert wird. Etwa im vergangenen Jahr vom damaligen Justizminister Heiko Maas: Ein Algorithmus spiegelt und verstärkt nur das, was er aus dem Internet aufsaugt. Die Software selbst hat keine eigene Meinung und wird auch in seltenen Fällen mit dem Ziel programmiert, homophob oder rassistisch zu sein.

Dennoch kritisieren Forscher und Netzpolitiker, dass Unternehmen ihre Programme gegenüber der Öffentlichkeit geheim halten.

Das sei unter anderem deshalb so gefährlich, weil mittlerweile kaum noch jemand nachvollziehen kann, wie ein Algorithmus überhaupt seine Entscheidungen trifft.

Der anerkannte IT-Sicherheitsexperte Bruce Schneier sagt sogar:

"Nicht einmal Google versteht seine Künstliche Intelligenz noch"

Die Folgen von Fehlentscheidungen der Programme könnten in Zukunft sogar noch gravierender werden. Gerade debattieren Experten beinahe irre klingende Fragen: Wie soll man lernende Programme kontrollieren, die selbst und ohne Mensch über das Abfeuern einer tödlichen Rakete entscheiden? Was, wenn ein in Schieflage geratener Algorithmus darüber entscheidet, wer eine rettende Krebstherapie bekommt, und wer nicht?

Zwar gibt das neue Datenschutz-Gesetz der EU erste Antworten und Richtlinien für solche Fragen vor. Weil die Entwicklung der Systeme aber so schnell geht, und weil sie so kompliziert ist, kommt die öffentliche Debatte kaum hinterher.

So stolpern eben auch die Unternehmen selbst immer wieder über neue Fallbeispiele, wie jetzt eben das Wort "Transe", die für Negativschlagzeilen sorgen.

So reagiert Yelp

Wir haben Yelp gefragt, wie es selbst zu den Problemen in seiner App steht. Die US-Version hat das Wort "Tranny" bereits aus den Anfragen entfernt.

Auch in Deutschland verspricht die Plattform gegenüber watson, die "Transen" so schnell wie möglich offline zu nehmen.

Eine Sprecherin schreibt:

"Wir wollen noch einmal klar sagen, dass kein Mensch diese Ergebnisse und Vergleiche programmiert hat"

watson

Der Fehler komme aus der Maschine, sei ein Resultat der Verarbeitung von historischen User-Suchanfragen.

Das stimmt sicher, auch kann Yelp die betroffenen Wörter entfernen. Solange der Algorithmus das Problem aber nicht versteht, wird er auch in Zukunft Vorurteile lernen und wieder ausspucken.

Mehr zum digitalen Leben: